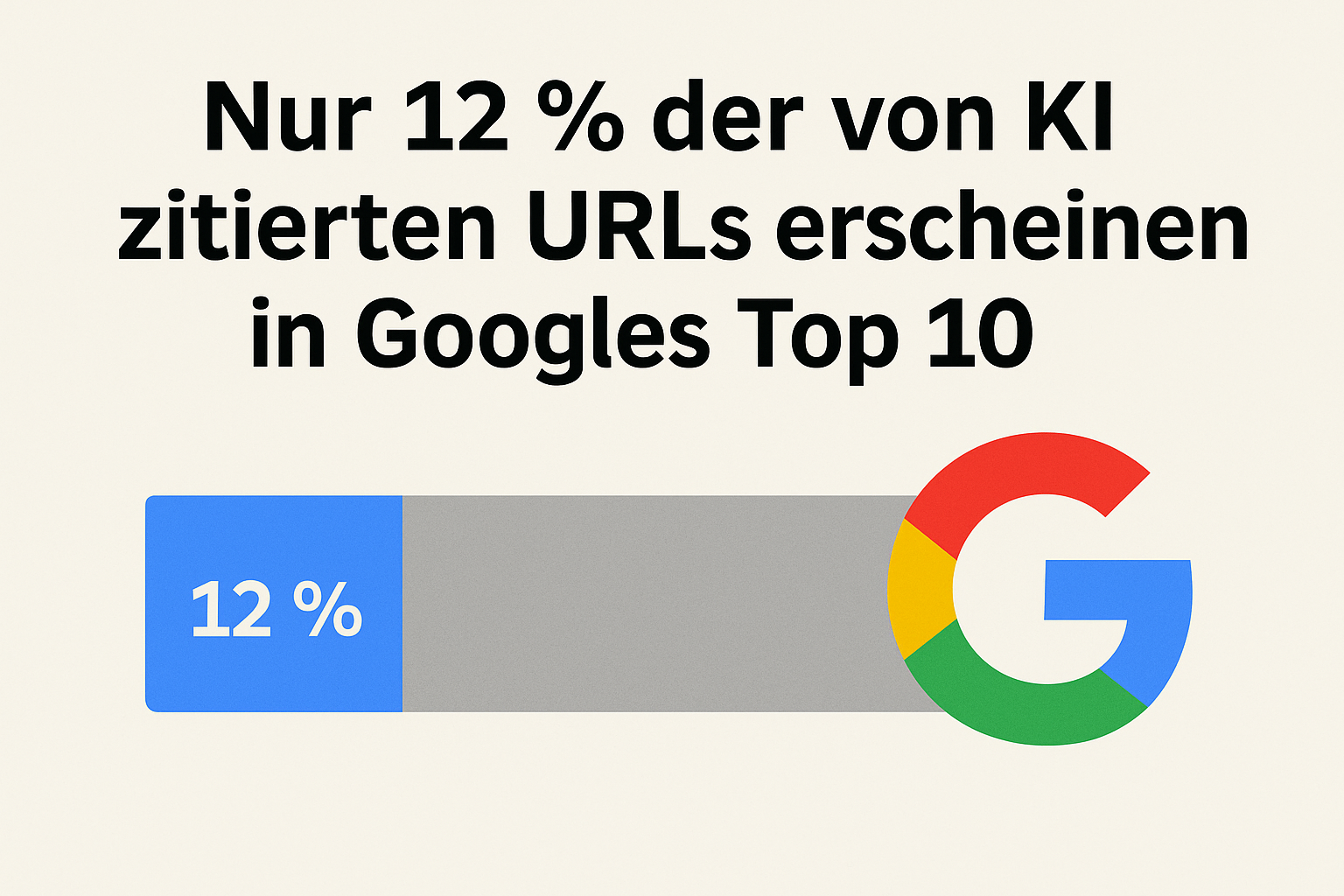

Nur 12 % der von KI zitierten URLs erscheinen in Googles Top 10

Werbung: Optimierung der Auswahl von KI-Tools

Smart AI Tool Selector

Die Auswahl des passenden KI-Tools kann angesichts der Vielzahl von Optionen eine Herausforderung sein. Der Smart AI Tool Selector vereinfacht diesen Prozess, indem er individuell zugeschnittene Empfehlungen auf Basis Ihrer Anforderungen und Präferenzen liefert. Mit wenigen Klicks sparen Sie Zeit und finden das ideale Tool für Ihre Bedürfnisse.

In einer aktuellen Analyse von Ahrefs auf Basis von 15.000 Suchanfragen zeigt sich ein überraschendes Ergebnis: Nur rund 12 % der von KI-Assistenzsystemen wie ChatGPT, Gemini oder Copilot zitierten URLs erscheinen in Googles Top 10 für dieselbe Suchanfrage. Perplexity bildet dabei eine deutliche Ausnahme und erreicht fast 30 % Übereinstimmung mit den Top-Ergebnissen.

Die Untersuchung zielte darauf ab, den inhaltlichen Überschneidungsgrad zwischen KI-generierten Quellen und den Suchergebnissen von Google und Bing zu messen. Der Durchschnittswert über alle getesteten Systeme hinweg liegt bei nur 11 % – ein Wert, der deutlich geringer ausfällt als viele Branchenexperten erwartet hatten.

Vier KI-Assistenten im Test

Für die Analyse wurden vier populäre KI-Tools untersucht: ChatGPT (inklusive in-text Zitate und Referenzen am Ende), Googles Gemini, Microsoft Copilot und Perplexity. Grundlage war eine Datenerhebung durch die Ahrefs-Data-Scientistin Xibeijia Guan, die 15.000 Long-Tail-Suchanfragen sowohl in Google als auch in Bing durchführte und anschließend identische Fragen an die KI-Assistenten stellte.

Beispiele für solche Fragen waren etwa:

-

„Wie viel kostet die Installation einer Überwachungskamera?“

-

„Wie bekommt man genug Protein, wenn man keine Milchprodukte essen kann?“

-

„Was ist die günstigste Vollkaskoversicherung?“

-

„¿Cuál es el mejor suplemento para la recuperación muscular?“

Alle von den KI-Systemen angegebenen Quellen wurden erfasst und mit den Ranking-Positionen in den jeweiligen Suchmaschinen abgeglichen. Dabei wurde unterschieden, ob eine URL in den Top 10, den Top 100 oder überhaupt nicht für die Suchanfrage gelistet war.

Nur 12 % Überschneidung mit Googles Top 10

Die zentrale Erkenntnis: Im Schnitt landen nur etwa 12 % der von den getesteten KI-Assistenten zitierten Seiten in Googles Top 10. Bei vielen Quellen handelt es sich um Seiten, die für die Ausgangsfrage gar nicht im Ranking auftauchen. Tatsächlich liegen rund 80 % der Zitate außerhalb der ersten 100 Google-Ergebnisse.

Perplexity sticht hier deutlich hervor: Das System, das stark auf Quellennachweise setzt, zitiert zu 28,6 % Seiten, die in Googles Top 10 für die jeweilige Anfrage ranken. Bei ChatGPT, Gemini und Copilot liegt dieser Wert eher um die 8 %.

Perplexity: Die Ausnahme im Test

Perplexity verfolgt einen anderen Ansatz als viele andere KI-Modelle: Jede Antwort wird mit Quellen versehen, und das System arbeitet mit einem eigenen Index (perplexitybot), statt direkt auf Googles oder Bings Daten zuzugreifen. Diese Fokussierung auf aktuelle und gut rankende Inhalte könnte erklären, warum Perplexity im Test am besten abschneidet.

Geringe Übereinstimmung mit Bing

Auch bei der Gegenüberstellung mit Bing zeigen sich niedrige Überschneidungswerte: Durchschnittlich erreichen die getesteten KI-Assistenten nur etwa 10 % Deckungsgleichheit mit den Top-10-Ergebnissen von Bing. Auffällig ist, dass Microsofts Copilot hier den besten Wert erzielt – was angesichts der direkten Anbindung an Bing wenig überrascht. Dennoch liegt auch Copilot klar unter der Marke von 20 %.

Warum KI-Zitate oft von den Suchergebnissen abweichen

Die geringe Überschneidung lässt sich dadurch erklären, dass KI-Modelle Suchergebnisse anders generieren als klassische Suchmaschinen. Sie verarbeiten nicht nur die ursprüngliche Nutzeranfrage, sondern erweitern diese oft um mehrere Varianten – ein Verfahren, das als „Query Fan-Out“ bekannt ist. Anschließend werden die Ergebnisse mittels Methoden wie dem „Reciprocal Rank Fusion“ zusammengeführt.

Das bedeutet, dass eine Seite, die für mehrere leicht abgewandelte Suchanfragen auf mittleren Positionen rankt, eher zitiert wird als eine Seite, die nur für eine einzelne Formulierung auf Platz 1 steht.

Zudem greifen einige Modelle, wie ChatGPT, nicht immer auf dieselbe Suchquelle zurück. Obwohl Bing die Standard-Suchbasis ist, legen neuere Tests nahe, dass in bestimmten Fällen auch Google-Ergebnisse verwendet werden – etwa wenn Bing keine passenden Seiten liefert.

Google AI Overviews: Deutlich enger am Ranking

Interessant ist, dass Googles eigene AI Overviews deutlich näher an den organischen Suchergebnissen liegen: 76 % der zitierten Seiten stammen hier aus den Top 10. Das zeigt, dass KI-Module in der Suchmaschine selbst stärker den klassischen Ranking-Faktoren folgen, während eigenständige KI-Assistenten wie ChatGPT oder Gemini unabhängiger vorgehen.

Implikationen für SEO und Content-Strategien

Für Website-Betreiber bedeutet das: Wer in den klassischen SERPs gut rankt, hat nicht automatisch eine hohe Chance, von KI-Assistenzsystemen zitiert zu werden. Um die Sichtbarkeit in KI-Antworten zu erhöhen, kann es sinnvoll sein, Inhalte für mehrere Long-Tail-Varianten einer Suchanfrage zu optimieren.

Tools wie der Ahrefs Keyword Explorer bieten hier Unterstützung: Über Parent Topics und Fragen-Reports lassen sich verwandte Suchanfragen identifizieren und gezielt inhaltlich abdecken.

Fazit

Die Studie zeigt, dass KI-Assistenzsysteme beim Zitieren nur in seltenen Fällen direkt auf die Top-Ergebnisse von Google oder Bing zurückgreifen. Perplexity bildet eine Ausnahme und zeigt, dass ein stärkerer Fokus auf Quellenangaben zu höherer Übereinstimmung führen kann.

Für Content-Strategen bedeutet dies, dass die klassische SEO-Optimierung weiterhin wichtig bleibt – jedoch ergänzt werden sollte durch die gezielte Abdeckung thematisch verwandter Suchanfragen, um die Chancen auf eine KI-Zitation zu erhöhen. Die Entwicklung bleibt dynamisch, und künftige Änderungen an den Such- und Zitierlogiken könnten die Überschneidung zwischen KI- und Suchergebnisquellen deutlich verändern.